お久しぶりです。

タイトルにもある通り、Mac Mini M4を買いました。

ほぼ自慢となりますが、購入した理由や経緯などを書いていきます。

購入した理由

巷で流行っているLocal LLMを、自宅に構築したいと思ったためです。

仕事でもAIを使うことが増え、その良さを実感する機会が多くなってきました。

自宅でAIを活用するとなると、有料サービスを使うのも良いですが、やはり自分で環境を構築してみたいという気持ちがありました。

また、遊びでAIを使ったものを作るのに、有料サービスを使うのはもったいないと感じ、Mac Mini M4の購入を決意しました。

(Mac Miniに課金していると言われると、何も言えませんが)

ほしいPCの条件

お金をかければ最強のLocal LLM環境を構築できますが、今回は趣味の範囲で楽しむため、以下の条件を満たすPCを探しました。

- 価格は10万円前後

- 可能であれば費用を抑えたい

- Gemini 3 27Bモデルが動く

- 2025年7月9日時点で、このモデルが最もいい感じに動く(個人的に)

- ミニPCであること

- できるだけ小さい方がいい

購入した Mac Mini M4 のスペック

購入までの紆余曲折は後述するとして、まずは購入したMac Mini M4のスペックを紹介します。

- Mac Mini M4

- Apple M4チップ

- 32GBユニファイドメモリ

- 256GB SSDストレージ

標準スペックのメモリを32GBに増設しました。

ストレージは256GBあれば十分だと考え、この構成にしました。

もし足りなくなったら、改造して2TBのSSDに交換しようと思います。

c.f. https://diysmartmatter.com/archives/5155

買うまでにいたった経緯

お待ちかね(?)の、購入に至るまでの紆余曲折です。

Mac Miniを買う前に、色々と調べました。

mac or windows

当初はMac Miniではなく、WindowsのミニPCを購入しようと考えていました。

ミニPCなら安価で、そこそこにLocal LLMを動かせるだろうと踏んでいました。

しかし、AIを動かすためにはGPUが必要で、GPUを搭載したミニPCとなると、かなり高価になってしまいます。

この記事を書いている2025年7月9日時点では、高性能なモデルを動かすには AMD Ryzen AI 9 HX 370 を搭載したミニPCが選択肢になるかと思います。

価格はおそらく140,000円ほどになるでしょう。

※ AMDの公式情報によると、Gemma 3の1Bから27Bモデルが動作すると記載されています。

この価格帯になると、Mac Mini M4とほぼ同価格帯になります。

Mac Miniなら、ユニファイドメモリによってGPUにも柔軟にメモリを割り当てられますし、普段からMacを使い慣れているという利点もあります。

Mac Studio M1Max も選択肢に

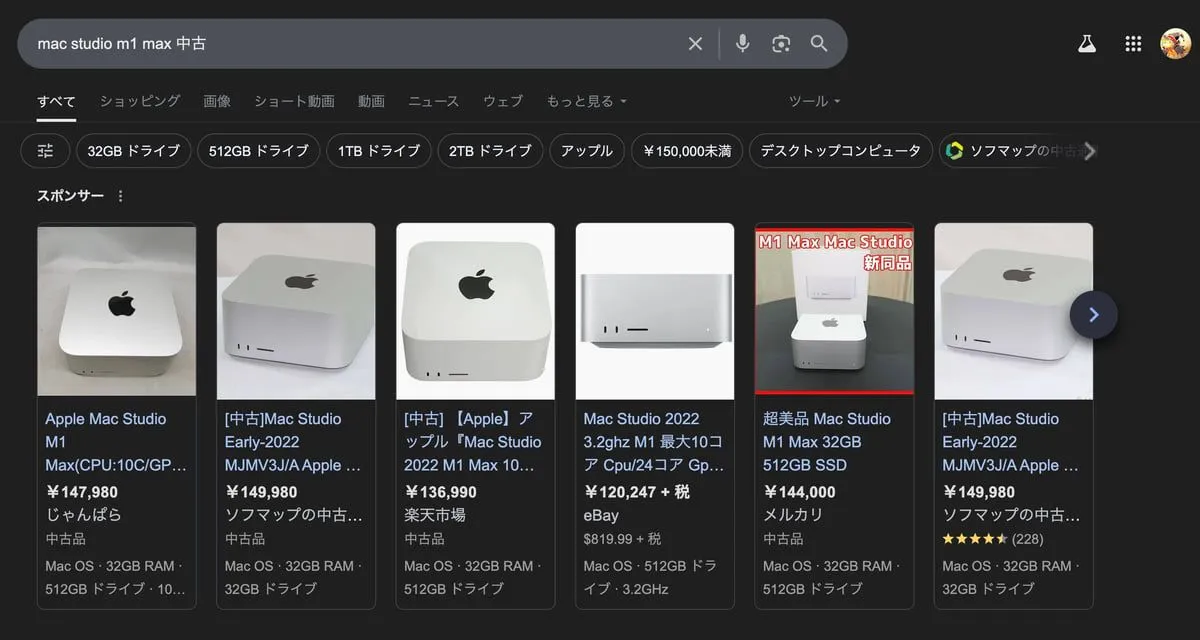

購入機種をMacに絞ったとき、選択肢に挙がったのが Mac Mini M4 と Mac Studio M1Max でした。

Mac Studio M1Maxの中古価格を調べると、150,000円以下で購入できることがわかりました。

しかも、RAMは32GB、ストレージも512GBと十分なスペックです。

筐体は重箱レベルの大きさですが、許容範囲です。

「これは魅力的だ」と思い、購入ボタンを押しかけたところで、一つ気になる点が見つかりました。

ストレージを自分で交換できないという点です。

ストレージの換装は頻繁に行うものではありませんし、512GBもあれば十分ですが、将来的な拡張性を考えると交換できないのはデメリットです。

c.f. 「Mac Studio」のSSDは取り外し可能、ただし交換&増設はソフトウェアロックされている

Mac Studio M1Maxは魅力的な選択肢でしたが、ストレージが交換できない点と、Mac Miniのコンパクトさが忘れられず、最終的に購入を断念しました。

Mac Mini M4 の使い心地

Mac Mini M4を購入してから3日ほど経ちました。

Gemini 3 27Bモデルを動かしてみましたが、特に問題なく動作しています(少しもたつくこともありますが)。

外観もコンパクトで、デスクの上に置いても邪魔にならないサイズ感です。

正直なところ、かなり気に入っています。

今後の予定

今後は、このMac Mini M4を使ってLocal LLM環境を構築していく予定です。

その過程も、少しずつ記事にしていきたいと思います。

よろしければ、ぜひご覧ください。

まとめ

今回は、Mac Mini M4を購入した理由と、その経緯について書きました。

Mac Mini M4は、Local LLM環境を構築する上で、非常に良い選択肢だと思います。

今後は、この環境でLocal LLMを活用したアプリをどんどん作っていきたいです。

完成した際には、また記事にしますので、よろしければ購読をお願いします。